爬虫第1关request基础"/>

爬虫第1关request基础"/>

request爬虫第1关request基础

- 任务描述

- 相关知识

- requests 的安装

- requests 的常用方法

- 编程要求

- 测试说明

任务描述

本关任务:编写一个 requests 请求网页的程序。

相关知识

为了完成本关任务,你需要掌握:requests 的安装和 requests 的常用方法。

requests 的安装

我们之前介绍了 urllib 库的使用,它是作为爬虫入门工具来介绍的,对新手理解 Python 爬虫的整个流程很有帮助。在掌握了爬虫基本思想流程后,就需要引入更高级的工具来提高我们的开发效率,这里就开始给大家介绍 requests 库的使用。

如果本地 Python 环境没有安装 requests,可以在命令提示符窗口输入命令pip install requests,安装 requests 模块,如下图所示。

requests 的常用方法

requests 可以用来模拟浏览器请求,下面介绍实现方法。以 GET 请求为例,实现代码如下所示:

res = requests.get(url, params=params, headers=headers)

参数说明:

- url :需要抓取的 URL 地址;

- params : 网址带参请求的方法,字典类型;

- headers : 请求头。

以百度搜索为例,现在有这样一个网址=requests,由主要网址 和参数 wd 组成,需要发起 GET 请求,方法有两种。

方法一:

import requests # 导包url = '=requests'header = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/""537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"}response = requests.get(url, headers=header) #模拟 get 请求response.encoding = 'utf-8' # 指定编码print(response.text) # 打印网页信息文本

方法二:

import requests # 导包url = ''header = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/""537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"}params = {'wd': 'requests'} # 定义参数response = requests.get(url, params=params, headers=header) #模拟 get 请求response.encoding = 'utf-8' # 指定编码print(response.text) # 打印网页信息文本

以上两种方法,都可以得到同一个网页的信息。可以看出,与 urllib 相比,requests 代码更加简洁。

上述代码还用到了响应对象(response)的属性,比如response.encoding和response.text,响应对象还有一些其它属性:

- encoding :响应字符编码 res.encoding = 'utf-8';

- text :字符串,网站源码;

- content :字节流,字符串网站源码;

- status_code :HTTP 响应码;

- url :实际数据的 URL 地址。

接下来演示一下 POST 请求,代码同样非常简洁,实现代码如下所示:

res = requests.post(url, data=data, headers=headers)

参数说明:

- url :需要抓取的 URL 地址;

- data : 提交常见的 form 表单的方法,字典类型;

- headers : 请求头。

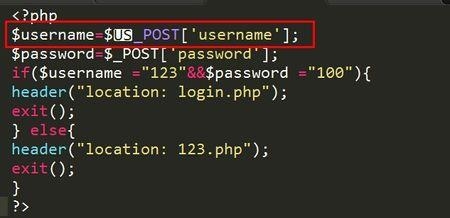

以豆瓣登录为例,登录网址为/,但这只是登录页面网址。为了找到真正的登录网址,需要打开开发者工具,然后在网页上实际进行登录操作,在Network项目下,选中文件basic,可以得到 post 请求的网址为,如下图所示:

如果将上图的页面往下拉,可以看到 data 参数为:

以下代码演示了模拟登录的 POST 请求:

import requests # 导包# 模拟请求头header = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/""537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36"}# 定义 data 信息data = {"name": "账号","password": "密码",}url = ""response = requests.post(url=url, headers=header, data=data) # 模拟登录请求response.encoding = "utf-8" # 定义编码html_content = response.textprint(html_content) # 打印网页信息

编程要求

根据提示,在右侧编辑器 Begin-End 区间补充代码,完善函数 get_html(),用 requests.get 请求获取网页信息。

测试说明

平台会对你编写的代码进行测试,当评测出现 Django 启动失败时,重新评测即可。

代码文件:

import requests

def get_html(url):

'''

两个参数

:param url:统一资源定位符,请求网址

:param headers:请求头

:return:html

'''

# ***************** Begin ******************** #

# 补充请求头

headers={}

# get请求网页

# 获取网页信息文本

# ***************** End ******************** #

return html

更多推荐

request爬虫第1关request基础

发布评论